競馬展開予測を畳み込みニューラルネットワーク(CNN)で勉強中のTigerOddsです。前回は学習させる画像の設計を行いました。

今回は畳み込みニューラルネットワークの設計を改善します。

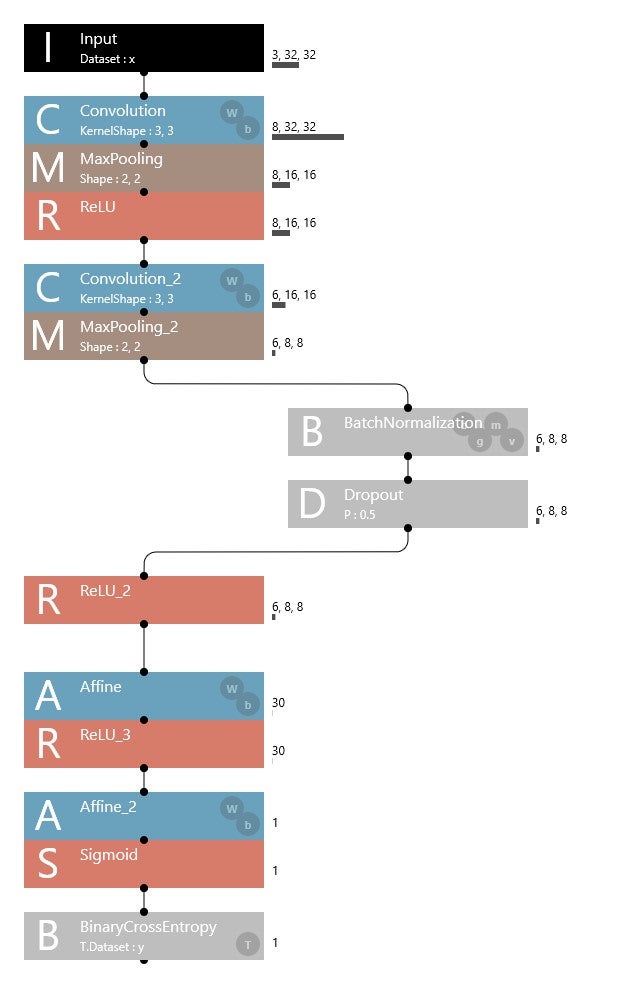

まず2つの設計要素Batch Normalization(B)とDropuout(D)を追加しました。

2つの要素については「楽しみながら理解するAI・機械学習入門」で勉強しました。

1)Batch Normalization(バッチ正規化)

https://data-analytics.fun/2021/09/11/understanding-batch-normalization/

2)Dropout(ドロップアウト)

https://data-analytics.fun/2021/11/13/understanding-dropout/

(B)と(D)をCNNのどこに追加するかというと

「全結合の後、活性化関数の前」という事で

図のように CMRのブロックのMとRの間にBNとDを挟んでみました。

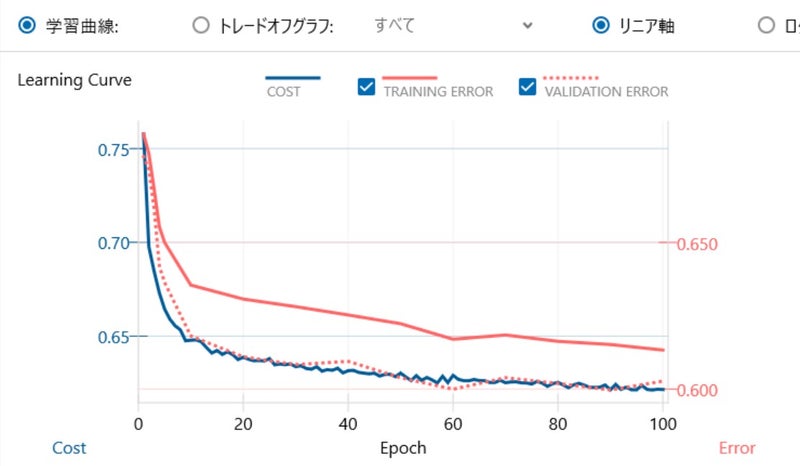

そして学習結果は90世代で正解率66.34%と記録更新!

BNとDはAI学習に効果あるんですね。

学習曲線も安定してます。

今までは30世代から過学習に陥りやすかったのが、

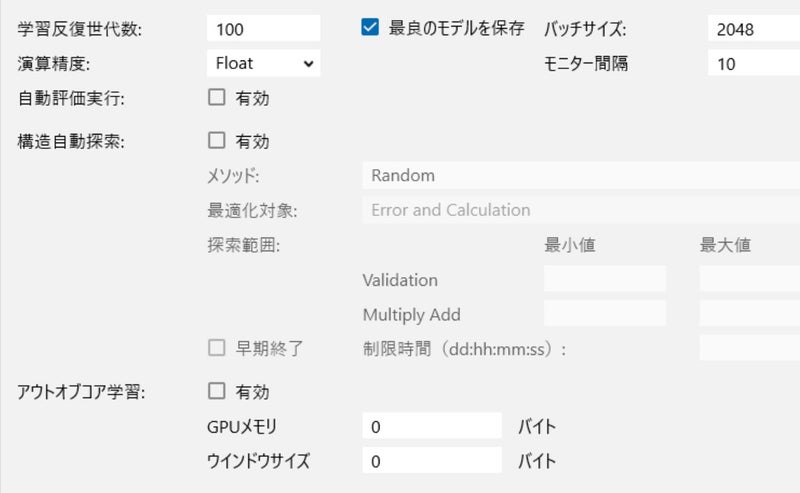

バッチサイズも2048と増やして100世代まで行けるようになりました

次はCMR→CM+B+ND+Rのブロック層を増やしてみる実験を行うとともに

含水率を追加してみますかね。それではまた